V posledních letech se nástroje AI staly neuvěřitelně vyspělými a zároveň nebezpečnými. Deepfakes ohrožují jednotlivce, firmy a na určité úrovni i celou společnost. Podívejte se na nejznámější případy podvodů a zjistěte, jak se v této digitální hře na kočku a myš účinně bránit.

Představte si nejmodernější technologii, která dokáže vytvořit falešné, ale velmi realistické obrázky nebo videa, kde lidé říkají nebo dělají věci, které ve skutečnosti nikdy neřekli ani neudělali. Děsivé sci-fi? Ani ne. Tohle je odvrácená tvář AI a nese název deepfake. Název vznikl spojením slov „deep learning“ (hluboké učení) a „fake“ (falešný). Díky umělé inteligenci – stejné technologii, která pohání virtuální asistenty a systémy rozpoznávání obrazu – můžeme dnes upravit již existující video nebo obrázek tak, že jen těžko rozpoznáte, co je pravda a co fikce.

S deepfake technologiemi se setkáte na mnoha místech a v různých podobách. Na sociálních sítích často kolují videa celebrit nebo politiků, kteří pronášejí šokující výroky. V médiích se deepfakes stávají nástrojem dezinformací a slouží k ovlivňování veřejného mínění. Podvodníci a kyberzločinci tuto technologii využívají k finančním podvodům, například napodobují hlas nadřízeného, aby přesvědčili zaměstnance k převodu peněz na cizí účet. V zábavním průmyslu se deepfake používá k tvorbě realistických speciálních efektů. Bohužel se však tato technologie zneužívá i k online obtěžování, kdy jsou nevinné osoby cíleně poškozovány falešnými intimními videi a fotkami.

Red flags ve videu, které by vás měly varovat

Dnes už existuje spousta volně dostupných AI nástrojů, které se dají zneužít k páchání trestných činů. Nejohroženější skupinou, jejíž členové se s vysokou pravděpodobností mohou stát oběťmi, je generace, která s moderními technologiemi nevyrostla. Ale to neznamená, že na lep nemůže skočit někdo z mladší generace. I když jsou deepfakes stále propracovanější, jsou tu určité signifikantní znaky, podle kterých je můžete odhalit.

- Pohyb očí: Pokud osoba na videu mrká nepřirozeně nebo vůbec, zbystřete.

- Nesoulad mezi pohybem rtů a mluveným slovem naznačuje, že zvuk byl dodatečně upraven.

- Nepřirozená mimika a strnulý výraz.

- Detaily obrazu jako rozmazané kontury obličeje, podivné osvětlení nebo nesrovnalosti v pozadí.

Firmy jako Google, Microsoft nebo Meta investují do vývoje nástrojů proti deepfakes, ale nespoléhejte se pouze na jejich ochranu. Bránit se musí každý sám. A jak?

- Nevěřte všemu, co vidíte na internetu. Kritické myšlení je naprostý základ. Dohledávejte informace z více zdrojů a porovnávejte je. U obrázků můžete použít zpětné vyhledávání obrázků v Google Images k nalezení původního zdroje a zjistit, zda byl obrázek pozměněn.

- Zkoušejte využívat aplikace, které dokážou deepfakes odhalit, jako je Deepware Scanner nebo Microsoft Video Authenticator, a neustále zvyšujte svou digitální gramotnost.

- Pokud si sami nejste jisti, jestli je něco pravda, nešiřte takový obsah dál jenom proto, že je virální nebo to dělají vaši známí.

Microsoft Video Authenticator je nástroj k detekci deepfake videí a obrázků. Funguje tak, že hledá drobné vizuální nesrovnalosti, které lidské oko nemusí zachytit, například nepřirozené změny v textuře obličeje nebo přechody barev.

Nejznámější deepfake kauzy, které obletěly svět

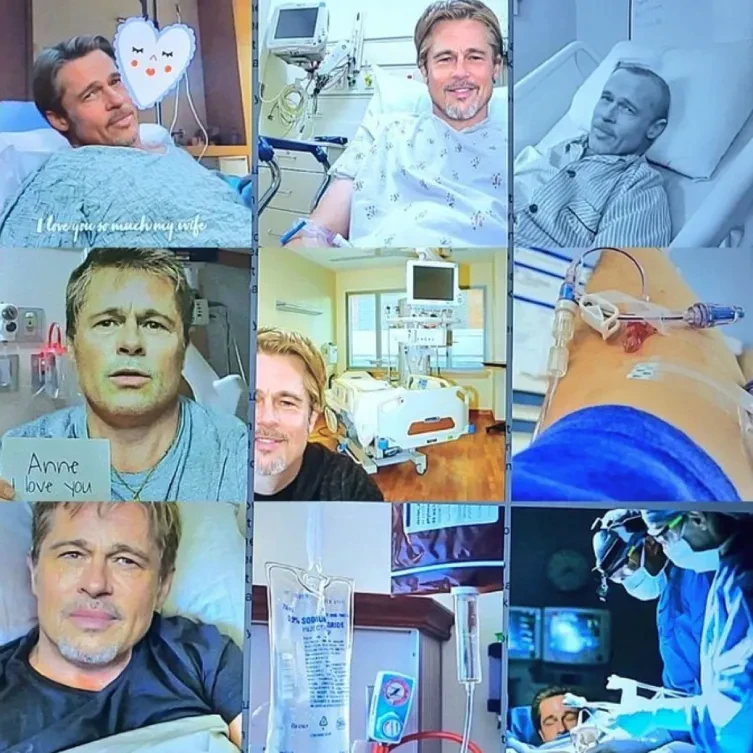

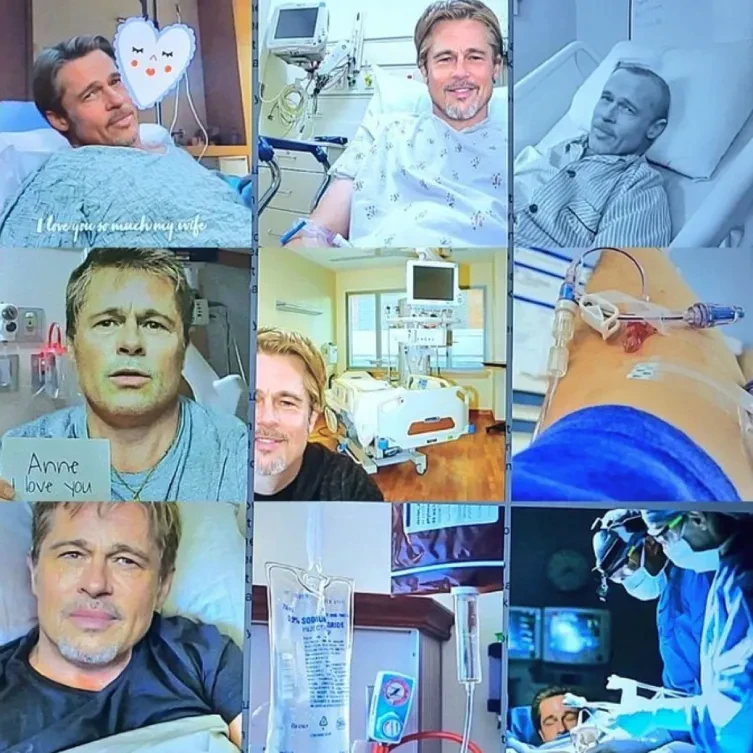

Deepfake má mnoho podob. Vzpomeňte si třeba na kauzu důvěřivé Francouzky, o které informovala média na začátku roku 2025. Žena byla podvedena útočníky, kteří použili falešné obrázky Brada Pitta, aby ji zmanipulovali a donutili uvěřit, že známému herci pomáhá v léčbě rakoviny. V průběhu více než roku a půl jí připravili o více než 800 000 eur.

Deepfake ale může stát spoustu peněz i firmy. V Hongkongu došlo k sofistikovanému finančnímu podvodu, při kterém útočníci využili falešný videohovor k napodobení finančního ředitele (CFO) nadnárodní společnosti. Zaměstnanec finančního oddělení byl podveden během videokonference, kde „CFO“ a další „účastníci“ byli ve skutečnosti deepfake rekonstrukce. Po této schůzce převedl 200 milionů hongkongských dolarů (přibližně 25,6 milionu dolarů) na určené bankovní účty.

Digitální demokracie není jen pojem

Sociální média mohou ovlivnit obrovské masy lidí a způsob, jakým se skutečně využívají, je dvousečný. Na jedné straně mohou zesílit hlasy minorit a podnítit žádoucí sociální změny, na druhé straně rozdělují společnost nebo probouzí nenávist. Zájmové skupiny šíří dezinformace, a dokonce mohou narušit demokracii jako takovou. Dezinformace se používají během politických kampaní, volebního období i dalších důležitých momentů.

V roce 2022 se například objevilo falešné video s ukrajinským prezidentem Volodymyrem Zelenským. Deepfake technologie byla využívána nejen k vytváření falešných videí a zpráv, ale také jako nástroj pro psychologické operace a šíření propagandy. V tomto konkrétním případě bylo video s falešným projevem Zelenského šířeno s cílem podkopat morálku ukrajinských vojáků a přesvědčit je, aby se vzdali a kapitulovali.

Digitální gramotnost hraje v tomto ohledu klíčovou roli. Je dobré se neustále vzdělávat, přistupovat k informacím s kritickým myšlením a ověřovat si fakta.

Zdroje obrázků: Freepik.com, blogs.microsoft.com a sociální síť X